ChatGPT: Eu não penso, logo eu não existo?

As ferramentas de linguagem gerativa de IA fizeram avanços inacreditáveis nos últimos anos. De acordo com um novo estudo da Universidade de Waterloo, o estilo de conversação humanizado do software resultou em mais de dois terços (67%) dos entrevistados acreditando que os Modelos de Linguagem de Grande Escala (LLMs) possuem um grau de consciência.

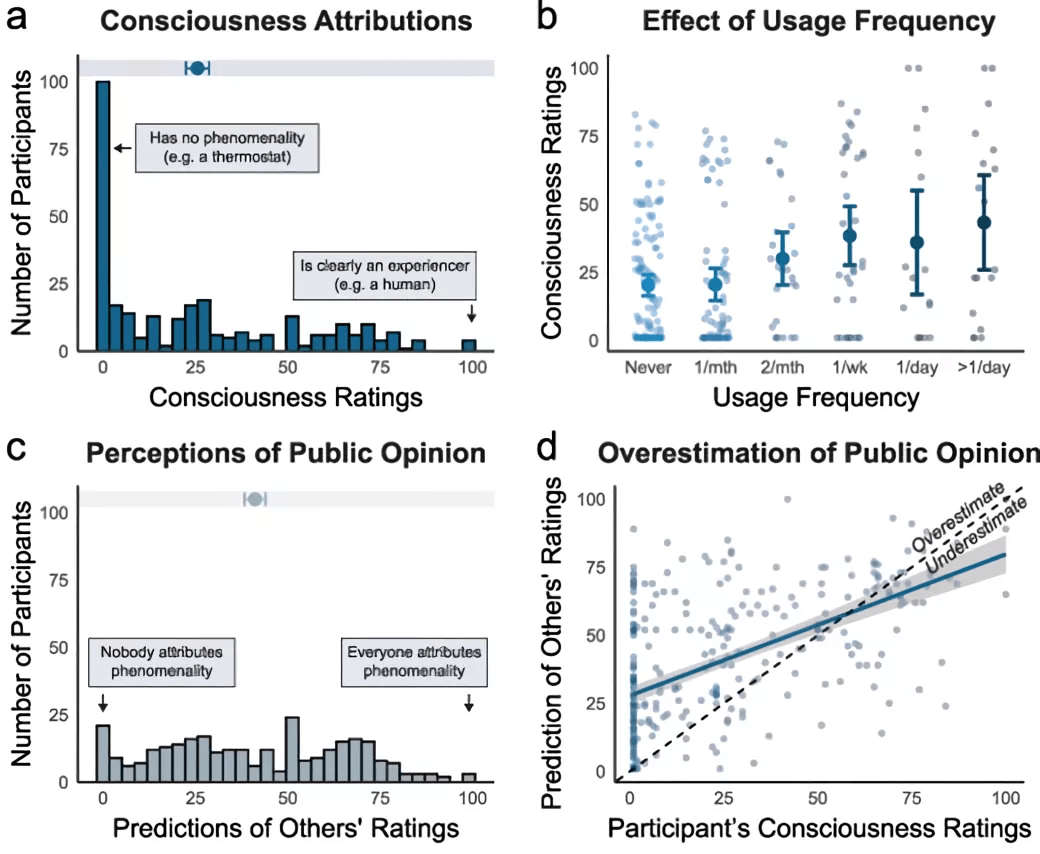

A pesquisa perguntou a 300 pessoas nos EUA se elas achavam que o ChatGPT poderia ter a capacidade de consciência e a habilidade de fazer planos, raciocinar, sentir emoções, etc. Elas também foram questionadas sobre a frequência com que usavam o produto da OpenAI.

Os participantes tinham que avaliar as respostas do ChatGPT em uma escala de 1 a 100, onde 100 significava confiança absoluta de que o ChatGPT estava experimentando consciência, e 1 confiança absoluta de que não estava.

Os resultados mostraram que quanto mais alguém usava o ChatGPT, mais provável era que acreditasse que ele possuía alguma forma de consciência.

“Esses resultados demonstram o poder da linguagem”, disse a Dra. Clara Colombatto, professora de psicologia na faculdade de Artes de Waterloo, “porque uma conversa sozinha pode nos levar a pensar que um agente que parece e funciona de forma muito diferente de nós pode ter uma mente.”

O estudo, publicado na revista Neuroscience of Consciousness, afirma que essa crença pode impactar as pessoas que interagem com ferramentas de IA. Por um lado, isso pode fortalecer laços sociais e aumentar a confiança. Mas também pode levar à dependência emocional dos chatbots, reduzir as interações humanas e levar a uma dependência excessiva da IA para tomar decisões críticas – preocupações que têm sido levantadas desde que o ChatGPT foi lançado ao público geral.

“Enquanto a maioria dos especialistas nega que a IA atual possa ser consciente, nossa pesquisa mostra que, para a maioria do público em geral, a consciência da IA já é uma realidade”, explicou Colombatto.

O estudo argumenta que, embora muitas pessoas não entendam a consciência da mesma forma que cientistas ou pesquisadores, o fato de que elas percebem esses LLMs como sendo de alguma forma sencientes deve ser levado em conta quando se trata de projetar e regulamentar a IA para uso seguro.

As discussões sobre a IA mostrar sinais de autoconsciência estão por aí há anos. Um dos exemplos mais famosos é o de Blake Lemoine, um ex-engenheiro de software do Google que foi demitido da empresa depois de tornar públicas suas alegações de que o sistema de desenvolvimento de chatbot LaMDA (modelo de linguagem para aplicações de diálogo) do Google havia se tornado senciente.

Perguntar ao ChatGPT se ele é consciente ou senciente resulta na seguinte resposta: “Eu não sou consciente ou senciente. Não tenho pensamentos, sentimentos ou consciência. Fui projetado para ajudar e fornecer informações com base em padrões de dados, mas não há consciência por trás das minhas respostas.” Talvez as pessoas acreditem que o chatbot está mentindo.