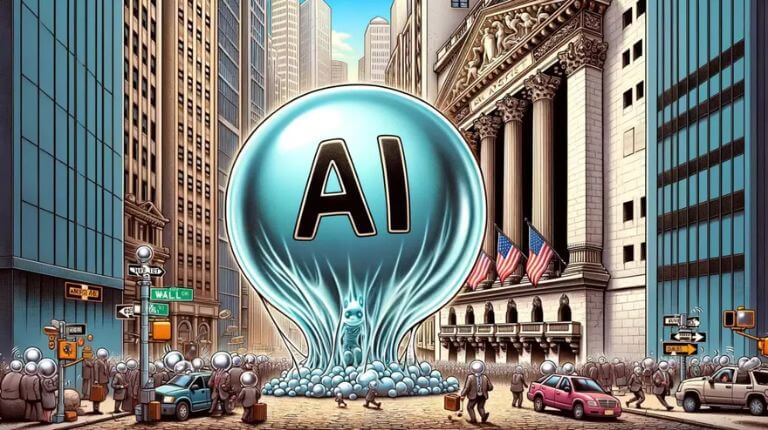

Serviços de IA generativa estão despertando a imaginação de quase todos os CEOs do setor de tecnologia no momento. Espera-se que eles substituam milhões de trabalhadores e automatizem quase tudo. No entanto, pesquisadores do MIT alertam que modelos de IA não compreendem realmente as “regras” de sistemas complexos.

Um modelo de linguagem grande (LLM) supostamente pode imitar a inteligência humana e fornecer respostas muito convincentes baseadas em um prompt textual do usuário. No entanto, o modelo está apenas prevendo, às vezes com uma precisão impressionante, as melhores palavras a serem colocadas após as anteriores em um contexto textual específico. Quando LLMs enfrentam condições imprevisíveis do mundo real, sua saída pode rapidamente se tornar pouco confiável.

Pesquisadores do MIT tentaram desenvolver novas métricas para verificar corretamente se sistemas de IA generativa podem entender o mundo, como avaliar sua capacidade de fornecer direções detalhadas nas ruas de Nova York. Segundo o estudo, os LLMs modernos parecem “aprender implicitamente” modelos do mundo, mas deve haver uma forma formalizada de avaliar adequadamente essa aparente demonstração de “inteligência”.

A equipe focou em transformers, um tipo de modelo de IA generativa utilizado em serviços populares como o GPT-4. Transformers são treinados em enormes bancos de dados de dados baseados em linguagem, tornando-se altamente hábeis na tarefa de previsão de texto. Os pesquisadores então avaliaram as previsões da IA generativa usando uma classe de problemas conhecida como autômatos finitos determinísticos (DFA).

A definição de DFA inclui diferentes tipos de problemas, como raciocínio lógico, navegação geográfica, química e jogos. Os cientistas do MIT escolheram dois problemas específicos — dirigir nas ruas de Nova York e jogar Othello — para testar a capacidade da IA de entender corretamente as regras subjacentes. “Precisávamos de campos de teste onde conhecêssemos o modelo do mundo. Agora, podemos pensar rigorosamente sobre o que significa recuperar esse modelo do mundo,” afirmou Keyon Vafa, pesquisador de pós-doutorado em Harvard.

Os transformers testados conseguiram, em geral, gerar direções precisas e movimentos válidos no Othello, mas tiveram um desempenho fraco quando os pesquisadores adicionaram desvios no mapa de Nova York. Nesse caso específico, todos os modelos de IA generativa foram incapazes de “ler” corretamente os desvios, sugerindo rotas que não existiam ou ruas com orientações “impossíveis”.

O desempenho da IA generativa se deteriorou rapidamente após a adição de um único desvio, relatou Vafa. Após fechar apenas 1% das ruas possíveis no mapa, a precisão do modelo caiu de quase 100% para apenas 67%. Os resultados do estudo mostram que LLMs baseados em transformers podem ser precisos em certas tarefas, mas eles não compreendem ou capturam modelos de mundo precisos. Ou, como o cientista da computação Alan Blackwell disse de forma famosa, estamos apenas automatizando “conversa fiada” repetidamente.